什麼是AI盡職調查

-

-

編輯: Tony

-

3739

- Wx Share

-

-

HR行業的盡職調查(Due Diligence),目前的AI大時代潮流,應用AI工具是必須的。設計思維成了最關鍵的產品核心靈魂。什麼是AI應用的出發點成爲關鍵點。

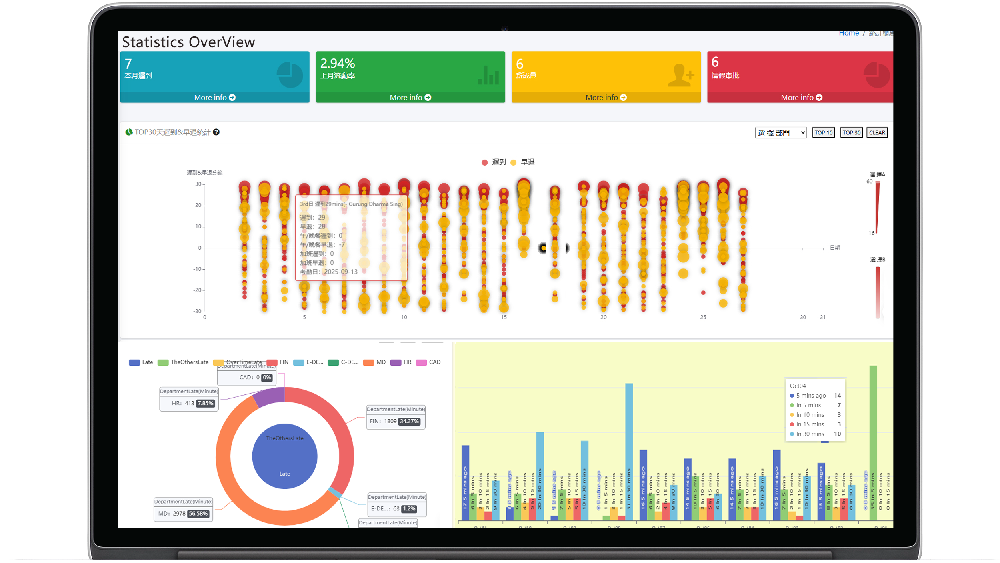

考勤與薪酬管理系統

考勤、薪酬、門禁、多功能集成系統,助力企業降本增效! Details

整合自動化考勤與薪酬計算, 高度安全的流程化,保障薪酬計算安全可控, 請假排班,多分支,連鎖,分銷, 多賬目,功能全面。

What is AI due diligence?

什麼是人工智慧盡職調查?

人工智慧(AI)盡職調查指運用人工智慧技術強化並自動化傳統盡職調查流程。 這種創新方法正在改變組織在做出重要商業決策前開展全面調查的方式。 其核心在於,人工智慧盡職調查利用機器學習、自然語言處理(NLP)和數據分析等先進技術,高效評估資訊,這些工具處理資訊的速度遠超人工審核。 在併購領域,人工智慧盡職調查的價值日益凸顯。儘管技術盡職調查在人工智慧應用方面仍相對落後,但法律團隊已開始運用人工智慧簡化盡職調查流程。

人工智慧盡職調查的主要優勢包括:

- 快速分析大量文件

- 識別模式與異常情況

- 減少人為錯誤

- 節省成本與時間

若實施得當,人工智慧系統可同時分析結構化數據(如財務試算表)和非結構化資訊(如合同和電子郵件)。這種全面分析有助於識別可能被忽視的潛在風險與機遇。 組織開展人工智慧盡職調查時必須謹慎。專家建議謹慎運用人工智慧技術,並對流程保持人工監督,而非盲目信任人工智慧的結果。 人工智慧驅動的盡職調查效果因具體情況而異。對於線上業務有限的小型私營企業,由於可用於分析的公開數據有限,此類盡職調查的效果較差。

人工智慧盡職調查(AI DD):技術概念與實踐方法

人工智慧盡職調查(AI Due Diligence,簡稱AI DD)是針對人工智慧系統或人工智慧相關專案/企業的全面評估流程。其核心目標是識別技術風險、驗證技術可行性、評估商業價值匹配度,確保人工智慧應用符合監管要求、倫理標準及業務目標。隨著人工智慧技術在金融、醫療、工業等領域的深度滲透,人工智慧盡職調查已成為企業併購、專案落地前及監管合規審查中的關鍵環節。其評估範圍覆蓋技術底層、數據治理、倫理合規、商業落地等多維度,不同於傳統資訊科技系統的盡職調查(後者更側重功能與穩定性)。

一、人工智慧盡職調查的技術概念

1. 核心定義與評估目標

人工智慧盡職調查本質是「技術風險與價值的量化式排查」,透過系統化方法論驗證人工智慧系統的「可靠性、安全性、合規性、可持續性」,最終解決三大核心問題:

- 技術層面:人工智慧系統是否真正「能用」(性能達標)、「好用」(穩定性/可維護性)、「安全」(無漏洞/偏見)?

- 合規層面:是否符合數據隱私法規(如GDPR、中國《個人資訊保護法》)、演算法透明度要求(如歐盟《人工智慧法案》分級監管)、倫理準則(如避免歧視性決策)?

- 商業層面:技術與業務目標是否匹配?是否具備規模化落地能力?後續迭代成本是否可控?

2. 核心評估維度(技術視角)

人工智慧盡職調查的技術評估圍繞「人工智慧系統生命週期」展開,覆蓋從數據輸入到模型輸出的全鏈條,核心維度如下:

| 評估維度 | 核心關注內容 | 風險點示例 |

|---|---|---|

| 數據治理 | 數據來源合法性、數據品質(完整性/準確性/時效性)、數據標註品質、數據隱私保護 | 未經授權採集數據(隱私違規)、標註錯誤率高(模型偏差) |

| 模型技術 | 模型架構合理性、性能指標(準確率/召回率/F1值)、泛化能力、可解釋性 | 模型過擬合(真實場景性能驟降)、黑箱模型(無法追溯決策) |

| 系統工程 | 模型部署架構(雲端/邊緣端)、運算能力支援、穩定性(故障率/回應時間)、可擴充性 | 運算成本過高(規模化不可行)、高併發下回應延遲 |

| 倫理與公平性 | 演算法偏見(如性別/種族歧視)、決策透明度、弱勢群體影響評估 | 招聘人工智慧對女性候選人評分偏低、貸款人工智慧歧視低收入群體 |

| 合規性 | 符合地區性人工智慧監管要求(如歐盟《人工智慧法案》高風險人工智慧清單)、行業標準(如醫療人工智慧的FDA認證) | 未申報高風險人工智慧應用(監管處罰)、醫療人工智慧未通過臨床驗證 |

二、人工智慧盡職調查的實踐方法

人工智慧盡職調查的實踐需結合「技術驗證工具」與「流程化方法論」,通常分為準備階段、執行階段、報告階段三個步驟。不同場景(如投資併購、專案上線前、監管審查)的側重點略有差異,但核心流程一致。

1. 準備階段:明確評估範圍與基準

此階段需對齊「評估目標」與「評估資源」,避免無邊界排查導致效率低下,核心動作包括:

- 定義評估邊界:根據場景確定重點維度(如投資人工智慧企業時側重「技術壁壘與商業化能力」,醫療人工智慧上線前側重「合規性與安全性」);

- 建立評估基準:明確關鍵指標的合格標準(如分類模型準確率需≥95%、數據標註錯誤率≤2%、回應時間≤500毫秒),基準需參考行業標準(如NIST人工智慧風險管理框架)或業務需求;

- 收集基礎資料:要求被評估方提供人工智慧系統文件(模型架構圖、數據流程圖)、數據來源證明、合規認證(如ISO 24089)、歷史性能報告等。

2. 執行階段:多維度技術驗證(核心環節)

執行階段是人工智慧盡職調查的核心,需透過「文件審查、技術測試、訪談驗證」相結合的方式,對各維度進行穿透式評估,具體方法如下:

(1)數據治理評估:從「源頭」排查風險

數據是人工智慧的「燃料」,數據問題會直接導致模型失效,評估方法包括:

- 數據合法性審查:

- 核實數據授權文件(如用戶知情同意書、第三方數據採購合同),確保無「黑產數據」或「未授權爬取數據」;

- 驗證數據脫敏效果(如身份證號、手機號是否符合匿名化標準,避免「可再識別」風險);

- 數據品質測試:

- 量化分析數據完整性(缺失值比例,如關鍵特徵缺失率>5%需重點關注)、準確性(與真實場景數據的一致性,如用戶畫像數據與實際行為偏差)、時效性(數據更新頻率,如即時推薦人工智慧需數據≤24小時更新);

- 抽樣檢查標註品質:隨機抽取10%-20%標註數據,由人工或第三方工具重新標註,計算「標註一致性率」(如目標檢測任務的IOU匹配度需≥90%)。

(2)模型技術評估:驗證「能力」與「可靠性」

模型是人工智慧的「核心引擎」,評估需兼顧「性能」與「穩健性」(抗干擾能力),方法包括:

- 性能指標復現:

- 基於被評估方提供的測試數據集,重新運行模型,驗證關鍵指標(如分類任務的準確率、召回率,生成式人工智慧的BLEU值、困惑度)是否與報告一致,避免「測試集過擬合」(即僅在特定數據集上表現良好,真實場景失效);

- 補充「真實場景測試」:使用未參與模型訓練的「野數據」(如企業實際業務數據)測試泛化能力,若性能下降超過10%,需分析原因(如訓練數據與真實場景差異過大);

- 模型穩健性測試:

- 對抗性測試:透過添加微小干擾(如圖像人工智慧中修改1%畫素、自然語言處理模型中替換同義詞),觀察模型決策是否發生錯誤(如人臉識別人工智慧在輕微遮擋下誤識率需≤0.1%);

- 極端場景測試:模擬邊緣情況(如金融人工智慧遇到「異常交易數據」、自動駕駛人工智慧遇到「暴雨+逆光場景」),驗證模型是否會崩潰或輸出危險決策;

- 模型可解釋性評估:

- 對「黑箱模型」(如深度學習),使用工具(如LIME、SHAP)分析關鍵特徵對決策的影響(如貸款人工智慧拒絕某用戶時,是否以「收入」而非「性別」為主要依據);

- 要求提供模型迭代記錄(如版本更新日誌、性能變化趨勢),評估模型是否具備「可迭代性」(如是否支援增量訓練,避免每次更新需重新訓練全量數據)。

(3)系統工程評估:確保「落地」可行性

人工智慧系統需依賴工程架構實現商業化落地,評估重點是「穩定性」與「成本可控性」,方法包括:

- 部署架構審查:

- 分析架構圖,確認是否適配業務場景(如邊緣端人工智慧需驗證終端設備運算能力能否支撐模型運行,雲端人工智慧需評估伺服器負載均衡能力);

- 核實運算成本:根據模型參數量(如100億參數的大型模型)與推理請求量,計算單位成本(如每1000次推理成本≤10元),判斷規模化後是否盈利;

- 穩定性與安全性測試:

- 壓力測試:模擬高併發場景(如電商人工智慧推薦系統在「雙11」峰值流量下),觀察回應時間、故障率(如請求失敗率需≤0.01%);

- 安全漏洞掃描:使用人工智慧安全工具(如IBM AI Explainability 360、OWASP AI Security Top 10)排查模型投毒(數據污染)、模型竊取(透過API反向推導模型參數)等漏洞。

(4)倫理與合規評估:規避「隱性」風險

倫理與合規是人工智慧盡職調查的「底線要求」,尤其針對高風險領域(醫療、金融、司法),評估方法包括:

- 演算法偏見檢測:

- 按敏感屬性(性別、年齡、地域)分層測試模型決策結果,計算「公平性指標」(如平等機會率、人口學平等率),若某群體的拒絕率比其他群體高20%以上,需排查是否存在偏見;

- 案例:招聘人工智慧需驗證「男性與女性候選人的通過率差異≤5%」,避免性別歧視;

- 合規性核實:

- 對照地區性法規(如歐盟《人工智慧法案》將「生物識別、醫療診斷」列為高風險人工智慧,需滿足嚴格的透明度與測試要求),確認是否完成必要申報或認證;

- 核實倫理審查記錄(如是否成立人工智慧倫理委員會,對高風險決策場景是否有人工復核機制)。

(5)訪談驗證:補充「非文件」資訊

技術文件可能存在「美化」或「遺漏」,需透過訪談關鍵人員(人工智慧演算法工程師、數據負責人、運維人員)驗證資訊真實性:

- 訪談演算法工程師:了解模型訓練過程(如是否使用過「捷徑特徵」導致泛化能力差)、性能瓶頸(如運算能力不足導致模型壓縮過度);

- 訪談數據負責人:確認數據更新機制、標註團隊資質(如醫療數據標註是否由專業醫生參與);

- 訪談業務負責人:評估技術與業務的匹配度(如人工智慧推薦系統是否真正提升用戶轉化率,而非僅追求「點擊率」)。

3. 報告階段:輸出風險與建議

執行階段結束後,需形成結構化的人工智慧盡職調查報告,核心內容包括:

- 評估摘要:簡要說明評估範圍、方法、核心結論(如「該人工智慧系統數據合規性達標,但模型泛化能力不足,需優化訓練數據」);

- 風險清單:按「高/中/低」風險分級列出問題(如「高風險:數據標註錯誤率15%,導致模型準確率不達標;中風險:回應時間超1秒,影響用戶體驗」);

- 改進建議:針對風險提供可落地的解決方案(如「標註錯誤率高:建議引入第三方標註審核機制;泛化能力差:建議補充真實場景數據進行增量訓練」);

- 結論與決策支援:基於評估結果給出明確建議(如「建議投資該人工智慧企業,但要求其3個月內完成數據治理優化;不建議醫療人工智慧上線,需補充臨床驗證」)。

三、典型場景的人工智慧盡職調查側重點

不同場景下,人工智慧盡職調查的評估重點差異較大,需針對性調整方法論:

| 場景 | 核心評估維度 | 關鍵關注指標 |

|---|---|---|

| 投資人工智慧初創企業 | 技術壁壘、商業化能力 | 模型專利數量、客戶留存率、單位獲客成本 |

| 醫療人工智慧產品上線前 | 合規性、安全性、臨床有效性 | FDA/NMPA認證、臨床測試準確率、數據隱私保護 |

| 企業人工智慧專案併購 | 技術整合難度、團隊穩定性 | 模型與現有系統相容性、核心演算法工程師留存率 |

| 監管機構人工智慧審查 | 合規性、倫理公平性 | 是否符合高風險人工智慧清單、演算法偏見率、決策透明度 |

四、人工智慧盡職調查的工具支援

為提升評估效率與準確性,可借助專業工具輔助執行:

- 數據品質工具:Talend(數據完整性分析)、Labelbox(標註品質核查);

- 模型測試工具:H2O.ai(模型性能復現)、IBM Adversarial Robustness Toolbox(對抗性測試);

- 合規與倫理工具:Microsoft Fairlearn(公平性檢測)、NIST AI Risk Management Framework(風險量化);

- 系統工程工具:JMeter(壓力測試)、Prometheus(穩定性監控)。

總結

人工智慧盡職調查是平衡人工智慧技術價值與風險的關鍵手段,其核心邏輯是「從數據到模型、從技術到合規、從文件到實踐」的全鏈條驗證。隨著人工智慧監管趨嚴與技術複雜度提升,人工智慧盡職調查需結合「技術工具的量化能力」與「行業經驗的定性判斷」,才能有效識別隱性風險,保障人工智慧應用的可持續落地。未來,隨著生成式人工智慧、多模態人工智慧的發展,人工智慧盡職調查還將新增「生成內容真實性」「跨模態數據一致性」等評估維度,方法論需持續迭代以適配技術演進。

要不要我幫你整理一份人工智慧盡職調查核心流程對照表,方便快速查閱各階段關鍵任務與工具?

行業資訊

鼎輝計算機系統有限公司

鼎輝計算機系統有限公司